Неоднократно писал, что сайты приходят на продвижение в ужасном состоянии. В каждом третьем обращении отказываем в SEO продвижении (а кто-то, заметьте, будет брать с вас деньги, пока вы готовы платить), если клиент не соглашается переделать сайт. Бывают случаи, что сайт настолько разросся, что переделывать его нереально дорого, тогда остается посоветовать только другие способы интернет-рекламы, например контекстную.

Я составил список базовых SEO требований. Если учесть их на этапе создания сайта, это сохранит в будущем деньги клиенту, нервы оптимизатору и значительно увеличит шансы на попадание сайта в ТОП.

Как я составлял требования? Я взял несколько своих технических аудитов по самым проблемным сайтам, которые я когда либо делал и собрал из них всё, кроме совсем специфичных ошибок.

Итак, базовые SEO требования для разработчиков сайтов. Возможно, что-то будет не понятно, тогда просто скопируйте и отдайте тому, кто делает сайт.

Верстка:

- Не использовать в верстке и дизайне теги заголовков H1-H6

- Также, не использовать в верстке любые теги форматирования текста (b, strong, i и т.п.) — всё делать через css

- только один h1 на странице

- использовать подзаголовки h2-h6, где предусмотрено логикой (описание, характеристики товаров, подзаголовки статей)

- использовать только в контентной части (например, в сайдбарах, подвале, шапке нельзя)

- Без скрытого контента на страницах (Закомментированный код, примечания или элементы верстки скрытые через css)

- Оптимизированные изображения в качестве элементов верстки (маленькая иконка не должна весить 500кб, фон не должен весить 2мб и т.п.)

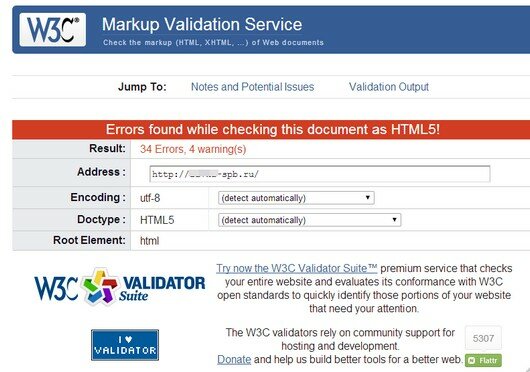

- Как можно меньше ошибок при валидации validator.w3.org. Это не критичное требование, но элементарных ошибок верстки не должно быть (например, не закрытые теги, пропуск обязательных атрибутов и т.п.)

- Одинаковое отображение в популярных браузерах.

- Сделать уникальный favicon

Движок:

- Не должно генерироваться лишних страниц (например, нельзя создавать отдельные страницы для каждого вида сортировки, создавать отдельные страницы для изображений, отдельного комментария и т.п.)

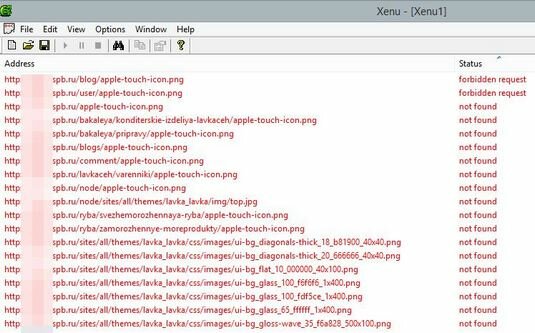

- С помощью программы Xenu (http://home.snafu.de/tilman/xenulink.html) можно просканировать сайт и увидеть странные и лишние страницы, битые ссылки, отсутствующие файлы и т.п. Также, см. статью создание структуры сайта.

- Крайне желательно (но не критично): Страницы с постраничной навигацией и сортировками должны иметь метатег rel=canonical указывающие на основную страницу (в идеале, вообще все страницы должны содержать это метатег).

- Страницы с поcтраничной навигацией должны иметь метатеги, указывающие следующую и предыдущую страницу <link href rel=»next(prev)»>

- Обязательно использование ЧПУ (не /?cat=2&tovar=123, а /categoriya/tovar123/)

- Возможность редактировать метатеги title, description, keywords у любых страниц (главная/категория/товар/статья/новость и т.п)

- Не смотря на то, что товар или страница может быть одновременно в разных категориях, он должен быть доступен только по одному адресу (основная категория)

- Наличие хлебных крошек.

- В URL товара должен отображаться путь до товара (http://site/cat1/subcat1/good)

проверка структуры сайта в программе Xenu

Настройки сервера и сайта:

- Для несуществующих страниц должна отображаться 404-я страница с ошибкой 404 в заголовке ответа сервера

- Все доступные по ссылкам страницы должны отдавать код сервера 200 ОК

- Наличие sitemap.xml с указанием всех страниц сайта (кроме служебных)

- Проверить карту на валидность https://webmaster.yandex.ru/sitemaptest.xml

Наличие robots.txt:

- закрыть служебные разделы, админку

- закрыть страницу результатов поиска

- прописать главное зеркало, карта сайта

- директивы отдельно для Яндекс и остальных роботов

Дублирование страниц:

Любая страница должна быть доступна только по одному адресу.

Настроить файл .htaccess, чтобы были редиректы:

- С www на без www

- С / на конце на страницу без /

- С index.php, index.html и т.п. на страницу (в корень папки)

- С https на http

т.е. всё, чтобы исключить доступности страницы по нескольким адресам. См. статью как найти дубли на сайте.

Требования к контенту:

На этот блок стоит обратить внимание тому, кто будет заниматься наполнением сайта.

- Контент на страницах должен быть уникален

- Метатеги title, description и тег h1 должны быть уникальным для всех страниц

- Соблюдайте длину метатегов (title 60 симв, description 150 симв), чтобы сайт выглядел аккуратно в результатах поиска

- Ко всем изображениям в контенте заполняйте атрибут alt

- В тексте желательно использовать подзаголовки h2-h6 и списки

Дополнение от 26.12.2016

Нашел у себя в заметках выдержу из исследований компании SEMRush, пусть это будет здесь:

11 самых частых ошибок в on-page SEO

Всего было выявлено 19 ошибок. Самыми распространёнными из них являются первые 11. Жирным шрифтом в итоговом списке выделены недочёты, оказывающие наиболее сильное негативное влияние на ранжирование ресурса.

- Дублированный контент– 50% сайтов;

- Отсутствие атрибутов alt – 45%;

- Дублирование тегов title– 35%;

- Нерабочие внутренние ссылки– 35%;

- Дублирование метаописаний– 30%;

- Низкое соотношение текста и HTML – 28%;

- Отсутствие метаописаний – 25%;

- Нерабочие внешние ссылки– 25%;

- Несколько тегов H1 – 20%;

- Отсутствие H1– 20%;

- Малое количество слов на странице – 18%;

- Дублирование содержания тегов H1 и title – 15%;

- Слишком много текста в теге title – 15%;

- Слишком много ссылок на странице – 15%;

- Отсутствие указания языка страницы – 12%;

- Временные редиректы – 10%;

- Нерабочие изображения– 10%;

- Отсутствие тегов title– 8%;

- Недостаточное количество текста в теге title – 4%.

Полезная статья спасибо! Думал что все знаю а нет, не знал, что в виджетах и в подвале нельзя использовать теги h1-h6, исправил!

Для того, чтобы продвигать сайт в поисковых системах, необходимо, чтобы он соответcтвовал ряду важных требований. В противном случае продвижение может быть или затруднительно, или вовсе невозможно.